(Article invité de Sylvain Deauré)

Rassurez-vous, ce n’est pas un Nième article pour vous annoncer la disponibilité de l’outil de désaveu de liens Google.

Plutôt quelques précisions quant à la manière dont fonctionne Google, et par là, pourquoi il faut être parano, tout comme pourquoi certains scénarios d’usage « NSEO » de cet outil ne sont pas crédibles.

Nombreux sont en effet les SEOs pénalisés par penguin qui se ruent sur l’upload de listes de liens « pourris ».

C’est prévisible : c’est déjà écrit plus ou moins comme ça dans l’évangile :

« Cette nuit, avant que le pingouin n’ait chanté 2 fois, par trois fois tu renieras les liens »

- Cela peut-il aider le site ainsi nettoyer à revenir ? C’est fort possible.

- Un site renié par trois fois va-t-il plonger ? Rien n’est moins sur

- Peut-on pénaliser un site en reniant ses liens en masse ? Sans doute, avec un volume conséquent

- Cet outil est-il une bonne chose pour les webmasters et les seos ? Non, assurément non.

Je m’explique.

Comment fonctionne Google ?

De manière schématique, Google a un algorithme de base, basé sur de très nombreux critères pondérés.

Au dessus de cet algorithme, s’empilent des filtres qui affinent (ou pénalisent) chacun à leur tour.

Pour chaque critère, pour chaque filtre, Google peut ajuster les paramètres, et pousser les manettes plus ou moins dans un sens ou dans l’autre.

Hop!, on donne plus de poids au title; hop!, on donne moins de poids au nom de domaine; hop!, on pénalise plus les ancres peu diversifiés, hop!.. etc.

Ces ajustements, très fréquents, sont le fait de décisions humaines, comme de rétroaction sur de gros ensembles de données.

Et oui… Google ne navigue pas à vue, au feeling, au doigt mouillé (même si parfois, on se demande).

« Bon alors les gars, aujourd’hui, on touche à quelle manette ? je pousse un peu par ici, je tire par là ? » huhu…

Non. Pour ajuster les manettes, Google se base avant tout sur des outils statistiques, et sur l’ensemble de données énorme qu’il a à sa disposition. Typiquement, il va attaquer le problème sous un angle particulier:

Bon, aujourd’hui on va examiner le problème des liens de faible qualité (ne me demandez pas ce que ça veut dire)

Bon, aujourd’hui on va examiner le problème des liens de faible qualité (ne me demandez pas ce que ça veut dire)

On prend un gros échantillon de sites témoins, on demande à des quality raters de dire si tel ou tel lien est bon ou mauvais.

On fait passer le même échantillon dans la moulinette, et on ajuste les paramètres pour que le résultat de la moulinette soit le plus proche possible du résultat humain. Sur l’échantillon.

C’est comme un sondage. On peut se planter.

La moulinette ne donne pas le même résultat que l’humain

Les critères donnés comme règle à l’humain peuvent être insuffisants ou biaisés.

Et même si c’est très proche, sur un autre jeu de données, ça peut diverger.

Mais bon, peu importe, on recommence, on prend des échantillons de plus en plus gros, on tente de se rapprocher de plus en plus de l’humain.

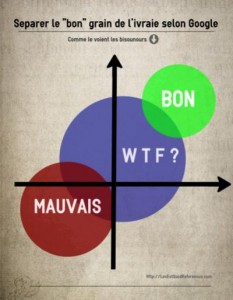

Pour les bisounours, tout va bien. Je ne fais que de bons liens, que du bon contenu, je suis un bon élève, j’écoute papa Google, je suis dans le vert, je dors tranquille. Merci Google de pourchasser ces méchants pirates rouges. Il y aura bien quelques effets de bord, des WTF qui ne sont ni rouge ni vert, mais bon, à la guerre comme à la guerre, non ?

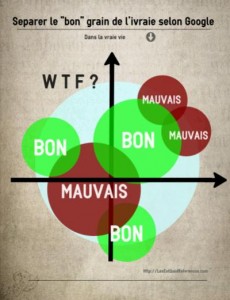

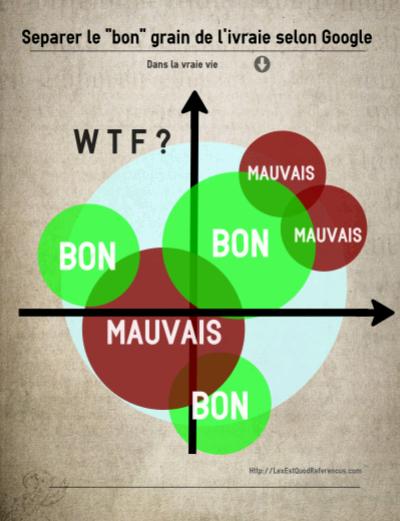

Dans la vraie vie, on est très loin d’un clivage aussi évident…

Dans la vraie vie, on est très loin d’un clivage aussi évident…

Qu’est ce qui est naturel, qu’est ce qui est de la « manipulation » aux yeux de Google ? Tout lien posé volontairement est par nature, manipulateur.

D’autre part, quand on prend un peu de recul, on se rend vite compte que le vert et le rouge sont bien plus proches et difficiles à discerner qu’on ne l’imagine naïvement (souvent bien plus proche, et aux contours moins net que le visuel ci contre ne le montre).

Un même lien peut être « propre » ou « sale » selon le site cible, son ancre, le texte qui l’entoure.

Un article qui a 200 commentaires peut être un super article de référence argumenté qui attire les réponses, comme une immonde page bourrée de commentaire en auto approve.

Chaque site « moyen » sur le net, a (peut être) un ou deux « bons » liens, quelques « mauvais » liens et une tripotée de liens « wtf »

La moyenne des sites est gris. Tristement grise.

Ce que Google essaye de faire, c’est de discerner des nuances de gris. Gris c’est bien, c’est moyen. Gris c’est pourri, mais c’est moyen, c’est normal.

Gris trop clair, c’est louche. gris trop foncé on tape.

Le problème de Google devient alors évident :

- il lui faut de plus en plus de données à digérer

- il lui faut de plus en plus de « notes » et « votes » humains pour étalonner finement sa moulinette.

Les quality raters, c’est bien, mais il faut les payer. Et puis ils ne savent pas forcément ce qui est « bien » ou « mal ».

D’ailleurs, même chez nous (Google), on a du mal à définir ce qui est bien ou mal, alors…

Ah, si seulement on pouvait utiliser les webmasters, les seos, et leur demander de bosser pour nous.. de dénoncer les sites, les liens qui ne sont pas bons… enfin, ceux dont ils pensent qu’ils ne sont pas bons…

Ca nous en ferait ça, des données, des retours humains qualifiés, des choses à mouliner…

Le truc, c’est qu’ils vont nous voir venir, personne ne va le faire; pas en quantité suffisante. Il nous faut du volume, des listes de liens plein la baraque, il faut alimenter la machine les gars, trouvez un truc !

Le truc ? Facile !

Suffit de donner un coup de pied dans la fourmilière. Un grand coup de tatane, on tape au pif (ou presque, on a quand même une vague idée) et on écrase des fourmis. Rouges, vertes, bleu, on s’en fout un peu. C’est le nettoyage de printemps.

Tiens, on va lui donner un nom d’animal sympa, comme « manchot » (penguin en anglais) ça va occuper les seos un moment, vont s’amuser tiens. S’arracher les cheveux, pleurer après leurs sites, retirer des liens.

Puis on les laisse mariner un peu, ok… là, on en remet une couche, allez, on y va franco, on secoue tout ça.

Maintenant, qu’on se le dise, fini les bls à la pelle messieurs, les liens peuvent vous pénaliser, le lien fait mal, le lien, c’est le mal. On veut tout égaliser, plus de liens, le lien ça sert à rien, le lien est manipulateur, le lien est menteur, le lien est voleur.

Oubliez le lien. Utilisez vos profiles google, utilisez +1, laissez nous vous tracer partout où vous allez, ne faites plus de lien.

Et quand c’est bien mur ? hein ? ben on lance notre outil de désaveu de liens pardi.

Le lien fait mal ? on peut arranger ça, facile. Faut juste le faire vous même, les cocos, ok ?

Vous allez bosser pour nous; c’est votre boulot les liens ? ben voilà des liens à virer, lâchez vous, on n’attend que ça.

(Fallait pas parler crowdsourcing au VLC2012, Kevin, fallait pas en parler…)

Dans une opération à deux temps, Google a embauché mieux qu’une armée de philippins. Google a embauché, sans débourser un centime, une armée de webmasters et seos qualifiés qui vont faire le ménage pour lui.

Bien sur, ça va marcher. Bien sur, il y aura un impact: c’est la carotte : individuellement, ponctuellement, les liens que vous allez désavouer ne compteront plus pour VOTRE site. ça oui.

Des sites vont sortir de pénalités, ça sera la deuxième ruée vers le désaveu, l’eldorado de la dénonciation, le règne de la balance…

Pénaliser les sites désavoués ? Pas directement. Google ne fonctionne pas comme ça.

Toutes les données seront agrégées. des points communs aux liens désavoués seront extraits des moulinettes, comparés aux indicateurs existants, serviront de base à de nouveaux indicateurs.

Et en sortie de moulinette, avec en grande partie les données bénévolement fournies par tous nos gentils seos de toutes les couleurs, Google aura entre les mains un filtre qui, il l’espère, fonctionnera pour un temps mieux que les autres.

Indirectement donc, oui. mais de manière globale. Google fait rarement de frappe chirurgicale. Les pénalités algorithmiques sont bien plus fréquentes que les manuelles.

Utilisation massive de machines, de robots, crowdsourcing, tracking, linkbaiting… tout ça pour amener du monde sur son money site…. Finalement, Google n’est qu’un black hat comme les autres.

Je sonne l’alarme !

Webmasters, Seos: on vous ment, on vous spolie !

Allez-vous comme un âne manger la carotte, ou au contraire vous assoir dessus ?

Cruel dilemme, n’est-ce pas ?

A propos de l’auteur:

Sylvain est un SEO, développeur, tombé tout petit dans la marmite du hacking (au sens noble du terme).

Il aime bidouiller et développer des outils étranges, comme son dernier né, xSpin, un synthétiseur de spin polymorphe.

NDE: Je remercie vivement Sylvain pour ce guest post et pour l’aide qu’il m’apporte lors du concours Penguinzophren.

Alex.

Quelques liens corrélés sur le sujet :

15 Responses to Par trois fois je les renierai